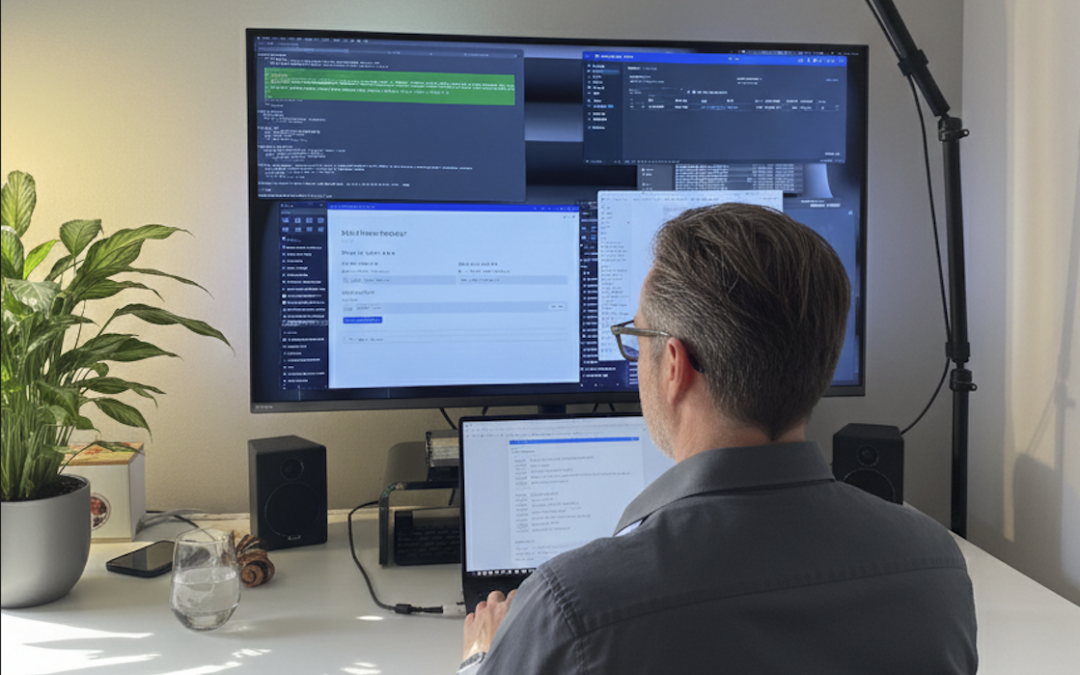

Ein Erfahrungsbericht von Michael – Requirements Engineer, ehemaliger Entwickler, und jetzt wieder ein bisschen Tech Lead.

Das Ergebnis vorweg

Am Wochenende habe ich eine vollständige Applikation gebaut. Als MVP. Mit Frontend, sauberer Architektur, Logging-Mechanismen, einer benutzerfreundlichen GUI und der Möglichkeit, das Ganze sauber zu erweitern.

Effektive Arbeitszeit: 16 Stunden.

Hätte ich das als klassischer Entwickler gemacht? 3-4 Wochen Minimum. Mit der Entwickler-Faustregel «nimm das Doppelte» eher 6 Wochen. Das sind etwa 252 Stunden.

Das ist nicht 10x. Das ist 15x.

Und nein, ich habe keine einzige Zeile Code selbst geschrieben.

Wer bin ich – und warum ist das relevant?

Ich stelle mich oft so vor: Ich bin ursprünglich Entwickler, aber ich spreche trotzdem gerne mit Menschen.

Mein Erfahrungsschatz umfasst die Softwareentwicklung, die technische Leitung von internationalen Dev-Teams und die Rolle als Product Owner. Ich kenne die Herausforderungen, wenn man Entwickler-Teams führt, und habe nach wie vor grosse Neugier für technische Details.

Aber: Mittlerweile bin ich weiter weg vom Code. Mein Fokus liegt auf dem Verstehen von Kundenbedürfnissen, dem WARUM hinter Anforderungen und der Kommunikation mit Entwicklern. Meine Arbeit mit Code beschränkt sich meist auf Automations, Low-Code-Plattformen oder kleine Skripte.

Mit meinem Trainerkollegen und Freund Matthias habe ich das AI Developer Bootcamp entwickelt. Meine Rolle dabei: Konzept, Didaktik, Struktur. Ich experimentiere zwar auch mit AI-Dev-Ansätzen wie Lovable, Bolt, Windsurf oder Roocode – aber eben: Experimentieren.

Bis jetzt.

10x Produktivität – Hype oder Realität?

Bevor ich in mein Experiment einsteige, kurz zu den Zahlen, die wir aus unserem Bootcamp kennen:

Wir haben über 150 Bootcamp-Teilnehmer ausgewertet. Das Ergebnis: Im Durchschnitt 82% schneller bei typischen Entwicklungsaufgaben mit KI-Unterstützung.

Das ist beeindruckend – aber es sind kontrollierte Übungen. Was passiert in der echten Welt, bei einem echten Projekt mit echten Constraints?

Genau das wollte ich herausfinden.

Der Auslöser: Qualitätssicherung für unser neues Modul

Im Zuge der Qualitätssicherung für ein neues Modul in unserem Bootcamp zum Thema Agentic Coding wollte ich unseren aktuellen Use Case selbst durchspielen. Mit Claude Code.

Ehrlich gesagt: Ich wollte das schon lange machen. Es ist manchmal eine echte Herausforderung, bei der Geschwindigkeit der KI-Entwicklung Schritt zu halten und sich mit jedem neuen Thema zu befassen.

Was ich am meisten liebe: Wenn das Experimentieren mit neuen Technologien mit der Lösung eines konkreten Problems zusammenfällt.

Und genau so kam es.

Das Problem: KI stösst an ihre Grenzen

Aktuell arbeite ich an der Lösung eines Kundenproblems. In den letzten Wochen hatte ich auf Langdock mit Agents gebaut – mit Custom Instructions, referenzierendem Wissen in Form von Markdown-Files und Knowledge per RAG.

Das Problem: Der Use Case war mit Assistants nicht lösbar. Selbst Claude 4.6 Reasoning – für unser Problem aktuell das beste Modell – stiess an seine Grenzen.

Ein einzelner Durchlauf kostete über API 1 USD. Das sind unglaubliche Kosten für KI. Dazu langsam und nicht wirklich zuverlässig.

Die Wende: Ein neues Design-Paradigma

Ich liebe es, die Grenzen von Technologien auszutesten. Man lernt dabei unglaublich viel.

Und dann kam der Gedanke: Nur weil wir KI haben, muss sie nicht überall die universale Superlösung sein.

Neues Design: Statt alles fluide mit der KI zu machen, bauen wir eine schlaue Logik – mithilfe der KI, aber mit deterministischen Regeln. Eine Kombination von Code und KI.

Das war der Wendepunkt.

Claude Code + Agent Harness = Strukturierte Agentenführung

Also: Claude Code installiert, unsere selbstentwickelte Agent Harness aufgesetzt – und los.

Was ist die Agent Harness?

Kurz gesagt: Ein strukturierter Rahmen, der KI-Agenten führt, statt sie einfach loszulassen. 90% der KI-Agenten scheitern, weil sie ohne klare Führung arbeiten. Die Agent Harness löst genau dieses Problem.

Sie ist übrigens Open Source und auf GitHub verfügbar. Wie man sie wirklich im Alltag anwendet – dafür ist unser Bootcamp da.

Mein Setup:

– Ich arbeite wieder mit Claude 4.6 Reasoning – aber diesmal stösst Claude nicht an seine Grenzen

– Ich schreibe keine Zeile Code

– Claude plant seine Schritte zunächst, wir diskutieren das zusammen, und erst dann geht’s los

– Er stellt Rückfragen, und ich kann nachjustieren

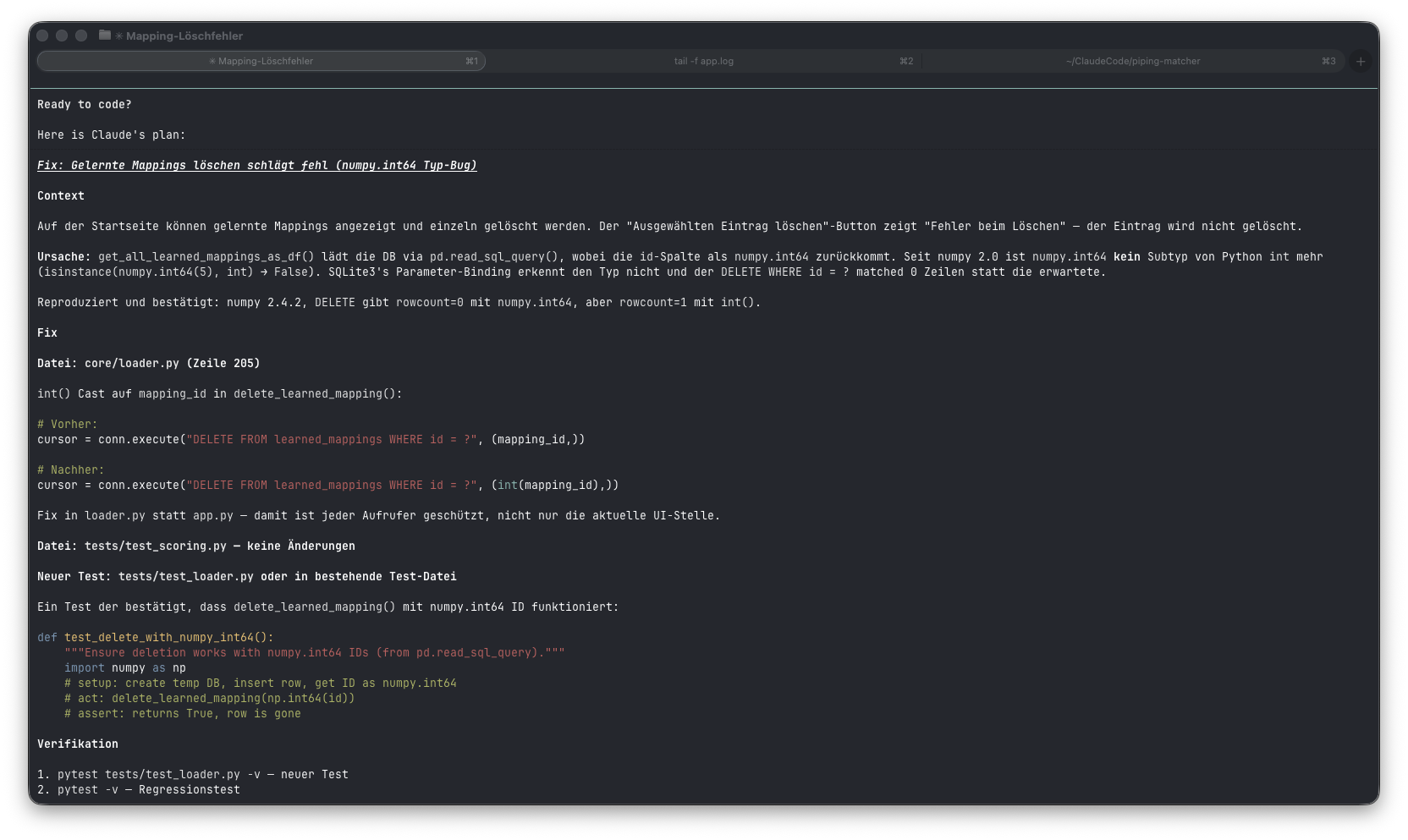

Claude Code hat einen Plan erstellt, wie es meine Anforderungen umsetzen will:

Die wichtigsten Prinzipien

Claude kennt unser Vorhaben genau:

– Den Techstack

– Den Coding Style

– Unser Change Management Approach

– Security Built In

– Test-Driven Development

– Und vieles mehr – alles dokumentiert in der CLAUDE.md und separaten Markdown-Files

Und hier kommt der entscheidende Punkt:

Ich kenne die Anforderungen und das zugrunde liegende Problem sehr genau.

– Wir haben ausführlich mit dem Kunden gesprochen

– Daten analysiert

– Ein tiefes Verständnis für das Problem des Kunden entwickelt

– In Interviews offene Punkte geklärt

Diese Anforderungen und Konzepte hatte ich bereits aus meiner Arbeit mit den Langdock-Agents detailliert dokumentiert – in Custom Instructions und separaten .md-Files.

Perfekt für das nächste LLM.

Mein Workflow: Natürliche Sprache statt Tippen

Jetzt kann ich der KI strukturiert und schrittweise die Anforderungen mitteilen.

Und der Clou: Ich bin sehr schnell auf der Tastatur. Aber ich komme niemals an die Geschwindigkeit heran, als wenn ich das einfach einem Entwickler *erzählen* würde.

Die Lösung: Ich diktiere.

Danach kurz prüfen, ob alles richtig erkannt wurde (das funktioniert erstaunlich gut, sogar mit Stimmen oder Musik im Hintergrund) – und weiter geht’s.

Ich nehme wieder die Rolle des technischen Leiters ein. Nur dieses Mal spreche ich mit der KI. Und ich muss nicht Tage auf Ergebnisse warten, sondern Minuten.

Zeit, in der ich kurz reflektiere. Zeit zum Nachdenken. Und für einen Kaffee.

Dann geht es weiter.

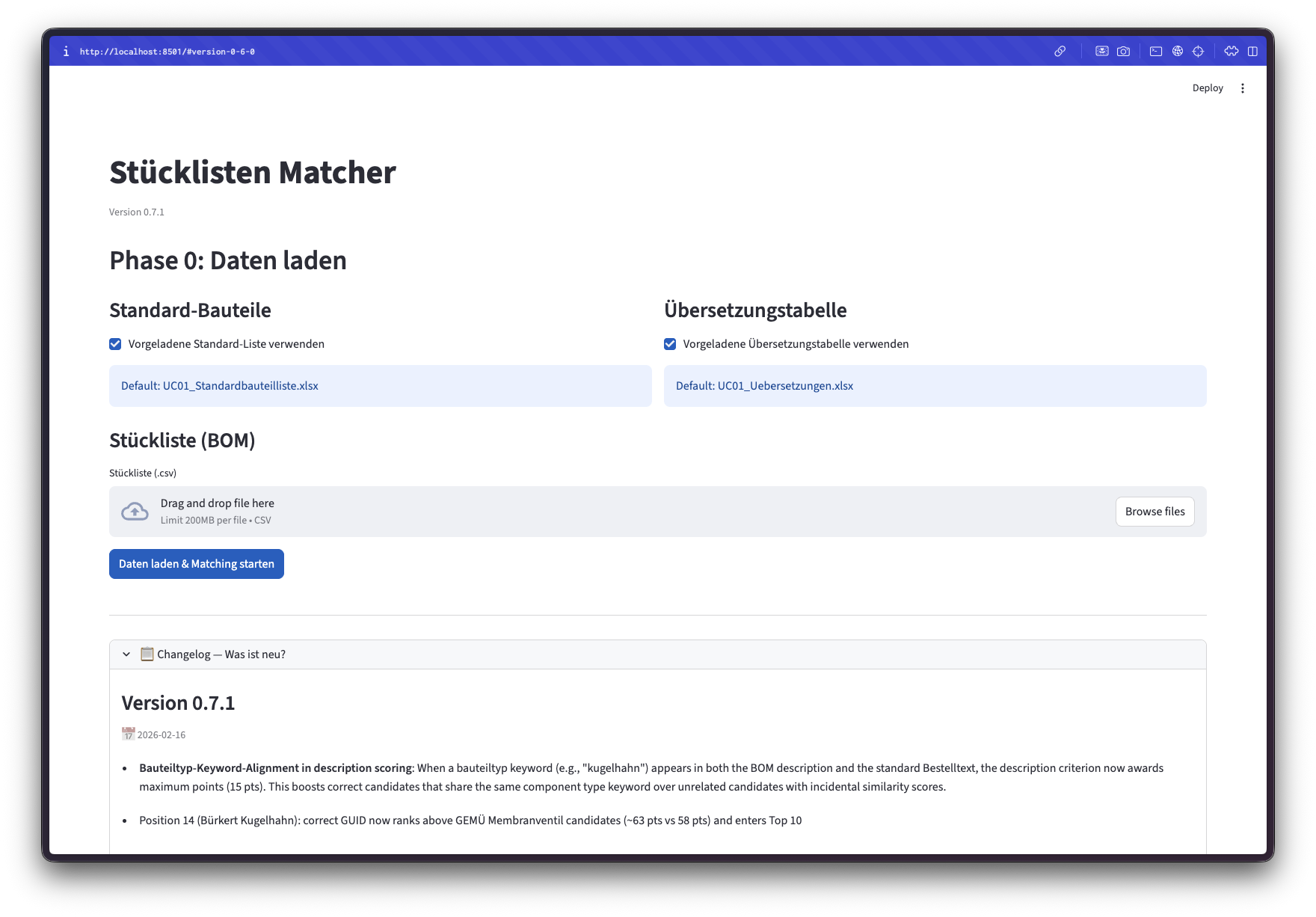

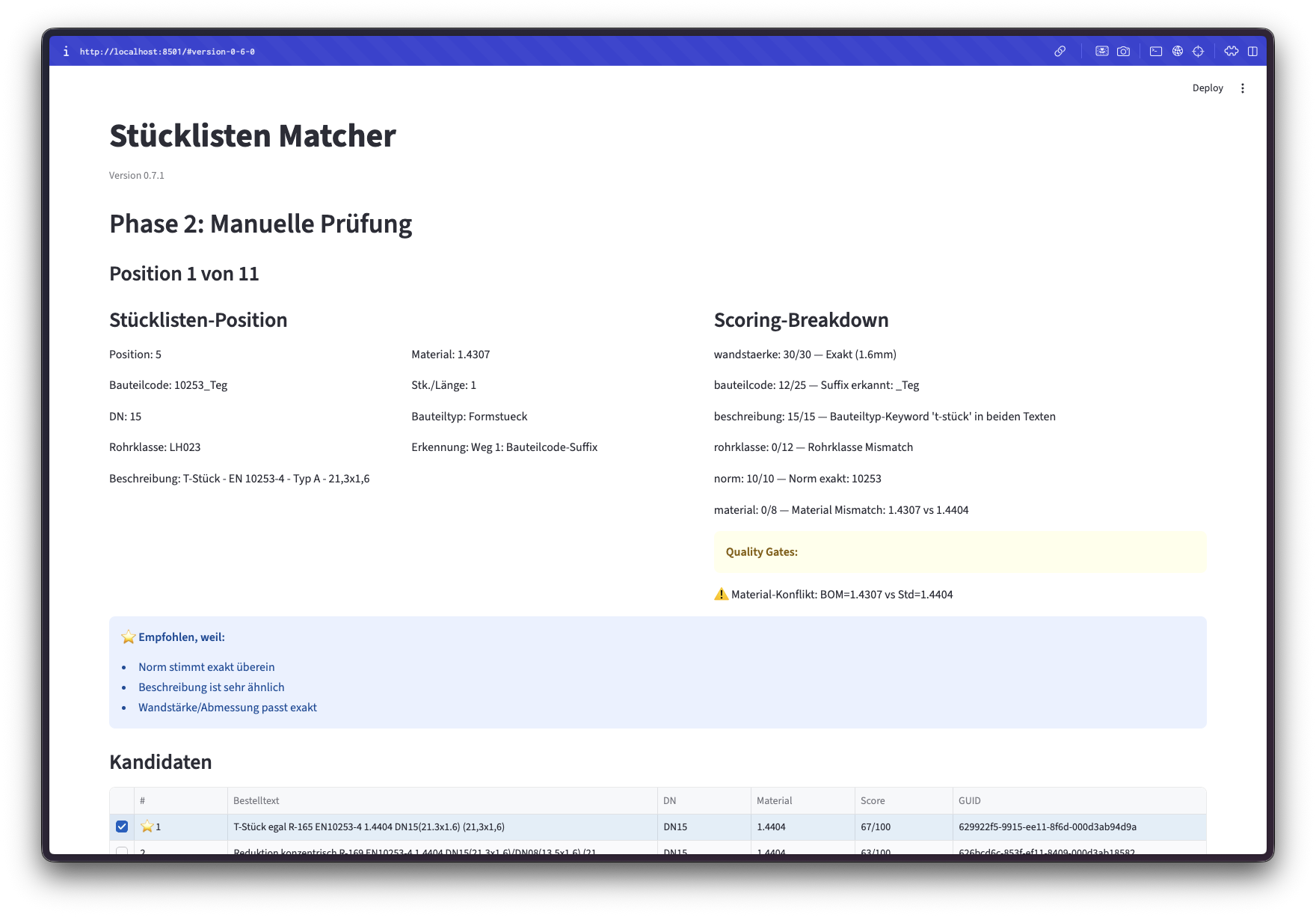

Das Ergebnis

Nach 2 Tagen habe ich:

✅ Eine vollständige Applikation mit Frontend

✅ Saubere MVP-Architektur

✅ Logging-Mechanismen

✅ Benutzerfreundliche GUI

✅ Die Möglichkeit, das sauber zu erweitern

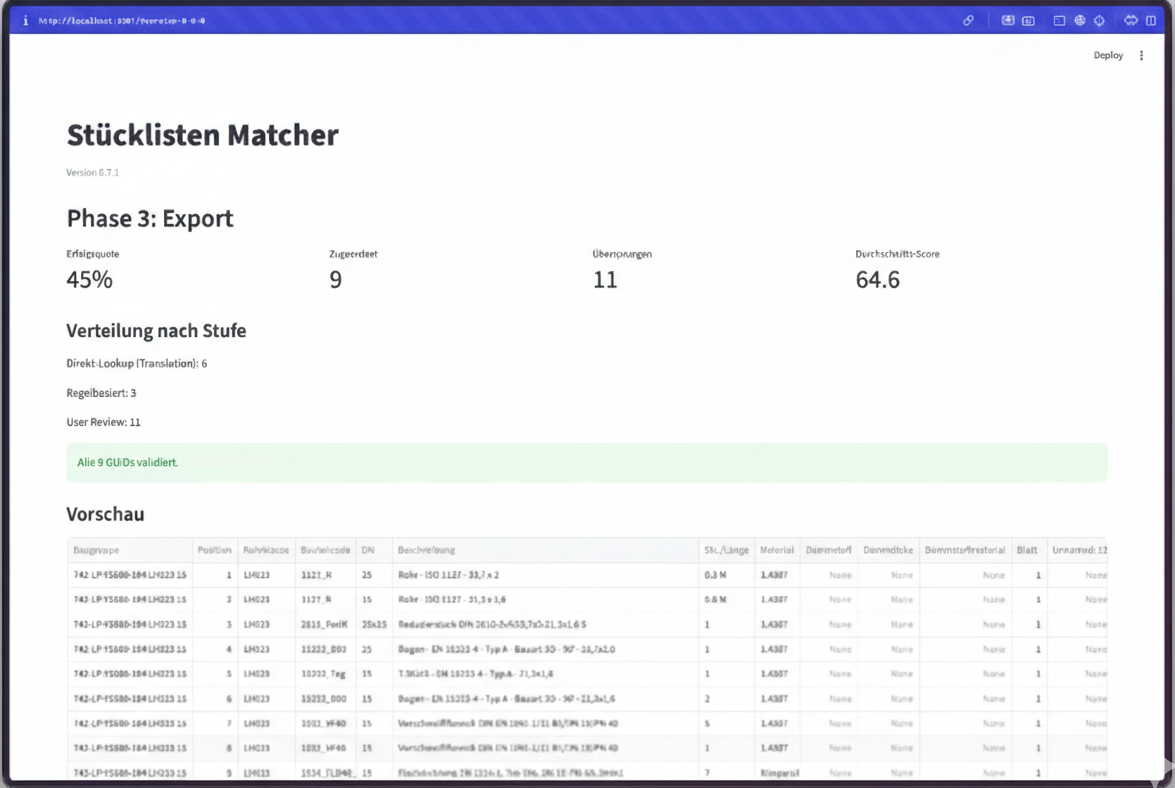

Screenshots von meiner Applikation:

Effektive Arbeitszeit: ca. 16 Stunden (2 Arbeitstage)

Wenn ich mir überlege, wie lange ich das als klassischer Entwickler gebraucht hätte:

– 3-4 volle Arbeitswochen Minimum

– Wahrscheinlich wäre ich zwischendurch noch in Bugs und Probleme gelaufen

– Mit der Faustregel «nimm das Doppelte» der Schätzung eines Entwicklers: 6 Wochen

– Das sind etwa 252 Stunden

Reine Entwicklertätigkeit: 10x ist die untere Grenze.

Bei mir waren es eher 15x.

Was das NICHT ersetzt

Kommunikation mit Menschen ersetzt das nicht.

Ich habe für die Analyse des Kundenproblems einiges an Arbeit investiert. Das tiefe Verständnis für das WARUM, die Stakeholder-Interviews, die Datenanalyse – das ist nach wie vor Handarbeit. Menschenarbeit.

Aber genau hier kommen die Themen Requirements Engineering und Development im Product Management Lifecycle zusammen.

Und es gibt auch für die Analysephase viele Möglichkeiten, effizienter zu arbeiten – siehe AI in Requirements Engineering.

Das Beste zum Schluss

Es macht mir mega Spass, daran weiterzuentwickeln.

Ich bin wieder ein bisschen Tech Lead. Nur eben anders. Ich diskutiere mit einer KI, ich reviewe Code, ich steuere die Architektur. Ohne selbst eine Zeile zu schreiben.

Das ist der Perspektivenwechsel, den wir in unserem Bootcamp vermitteln.

Für wen ist das relevant?

Nicht nur für Entwickler.

Wenn du aus dem Requirements Engineering kommst, Business Analyst oder Product Owner bist – und einen technischen Hintergrund hast – dann ist das AI Developer Bootcamp ein echter Perspektivenwechsel.

Du lernst nicht nur Claude Code, sondern viele verschiedene Ansätze:

– Agentic Coding mit verschiedenen Tools

– Die Agent Harness Methodik (Open Source!)

– Wie du KI sinnvoll in deinen Workflow integrierst

– Was funktioniert – und was nicht

Das nächste Bootcamp startet am 3. März.

Bist du dabei?

FAQ

Brauche ich Entwickler-Erfahrung für Claude Code?

Ein technisches Grundverständnis hilft enorm. Du musst nicht selbst coden können, aber verstehen, was Code tut. Genau das trainieren wir im Bootcamp.

Wie viel kostet Claude Code?

Claude Code läuft über die Anthropic API. Die Kosten hängen vom Modell und der Nutzung ab. Für mein 2-Tages-Projekt lagen die API-Kosten bei etwa 15-20 USD – deutlich günstiger als der vorherige Ansatz mit 1 USD pro einzelnem Durchlauf.

Was ist die Agent Harness?

Ein strukturierter Rahmen für die Führung von KI-Agenten. Open Source verfügbar, aber die wirkliche Anwendung lernt man am besten in der Praxis – dafür ist unser Bootcamp da.

Funktioniert das auch für komplexe Enterprise-Projekte?

Ja, aber mit Einschränkungen. Die Prinzipien skalieren, aber du brauchst klare Strukturen. Genau das ist der Unterschied zwischen «KI ausprobieren» und «KI systematisch einsetzen».

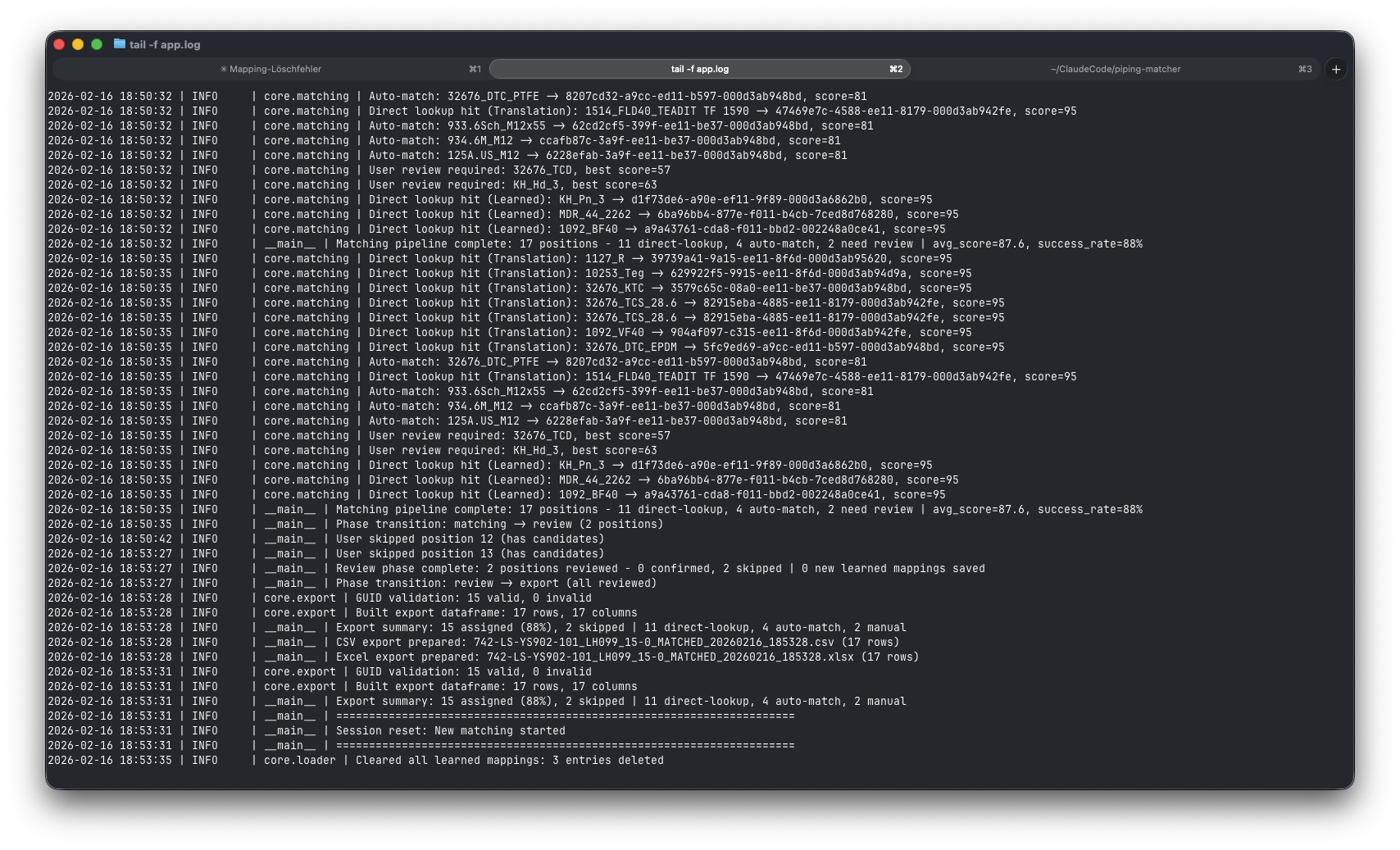

Im Logfile der Applikation kann ich mit Claude Code gemeinsam Fehler analysieren:

Michael ist Requirements Engineering Experte, ehemaliger Software-Entwickler und Trainer bei Obvious Works. Zusammen mit Matthias leitet er das AI Developer Bootcamp.

Michael (Mr. Miroboard) Mey

Michael ist ein Trainer, der nicht nur durch sein Wissen, sondern auch durch seine Leidenschaft besticht.

Zu Michaels Trainerprofil

Zu seinem LinkedIn Profil